Jak przestać pisać dla Google, a zacząć pisać dla LLM-ów?

| Przemysław Boreczek | SEO/SXOPrzez 20 lat uczyliśmy się pisać dla robotów Google. Teraz musimy nauczyć się pisać dla innych robotów — LLM-ów. I to zupełnie inna gra.

Tradycyjne SEO oparte na słowach kluczowych, backlinkach i strukturze nagłówków już nie wystarczy. Coraz więcej użytkowników otrzymuje odpowiedzi bezpośrednio od AI — bez klikania w wyniki wyszukiwania. Google AI Overviews pojawiają się w odpowiedzi na ponad 30% zapytań informacyjnych. ChatGPT ma setki milionów aktywnych użytkowników. Perplexity notuje wzrosty liczone w dziesiątkach procent miesięcznie.

Konsekwencja? Możesz rankować na pierwszej pozycji i odnotować spadki ruchu, bo AI daje odpowiedź za Ciebie. Możesz też nie być w top 10 i być cytowany przez ChatGPT. Pisanie dla LLM to nowa kompetencja, którą musisz opanować.

W tym artykule tłumaczymy nowy paradygmat — od teorii (chunki, wektory, embeddingi) po praktykę (nasze narzędzia do analizy keyword gap i optymalizacji pod AI Overviews).

Spis treści:

Dlaczego tradycyjne SEO już nie wystarczy

Tradycyjne SEO już nie wystarczy, ponieważ coraz więcej użytkowników otrzymuje odpowiedzi bezpośrednio od AI (ChatGPT, Perplexity, Google AI Overviews) bez klikania w wyniki wyszukiwania. Aby być widocznym, treści muszą być nie tylko zoptymalizowane pod Google, ale też „przyjazne dla LLM-ów” — czyli strukturalnie i semantycznie przygotowane do cytowania przez modele językowe.

Zmiana zachowań użytkowników

Ludzie coraz częściej zadają pytania bezpośrednio narzędziom AI — ChatGPT, Perplexity, Gemini — zamiast wpisywać frazy w wyszukiwarkę. Google odpowiada na to za pomocą AI Overviews, które dostarczają odpowiedź bez konieczności klikania. Zero-click searches rosną z roku na rok, a użytkownicy przyzwyczajają się do natychmiastowych, syntetycznych odpowiedzi.

To nie jest chwilowa moda. To zmiana porównywalna z przejściem z katalogów stron do wyszukiwarek — fundamentalna reorganizacja sposobu, w jaki ludzie szukają informacji.

Konsekwencje dla twórców treści

Nowa rzeczywistość wymusza nowe metryki sukcesu. Obok „organic traffic” pojawia się „cited by AI”. Obok pozycji w SERP — obecność w odpowiedziach generowanych przez modele językowe.

Paradoks nowej ery

Tradycyjne SEO nadal ma znaczenie. LLM-y często bazują na wynikach wyszukiwania Google, więc wysoka pozycja zwiększa szanse na cytowanie. Autorytet domeny wpływa na to, czy AI uzna Twoje źródło za wiarygodne.

Ale samo SEO już nie wystarczy. To fundament, na którym budujesz — ale potrzebujesz dodatkowej warstwy optymalizacji pod AI.

Nowy cel: być źródłem dla AI

Kiedyś celem było „rankować wysoko”. Teraz cel się rozszerza: być źródłem, które AI wybierze do zacytowania. To wymaga innego podejścia do struktury treści, innego myślenia o tym, jak piszemy i formatujemy informacje.

Jak LLM-y „czytają” i wybierają źródła do cytowania

LLM-y wybierają źródła do cytowania na podstawie wyszukiwania semantycznego — porównują znaczenie pytania użytkownika z fragmentami (chunkami) dostępnych treści. Decydują czynniki takie jak: relewancja semantyczna, wiarygodność źródła, struktura ułatwiająca ekstrakcję odpowiedzi oraz bezpośredniość (odpowiedź na początku sekcji, nie zakopana w tekście).

Retrieval-Augmented Generation (RAG) — jak AI sięga po źródła

LLM nie „wie” wszystkiego. Jego wiedza kończy się na dacie treningu. Dlatego nowoczesne systemy AI używają mechanizmu RAG (Retrieval-Augmented Generation) — model sięga do zewnętrznych źródeł, pobiera istotne fragmenty, a następnie generuje odpowiedź na ich podstawie.

Musisz wiedzieć jedno: AI nie analizuje treści ciągiem. Mechanizm opiera się na fragmentach, czyli chunkach. Dla bota Twój artykuł to nie jednolita całość, ale zbiór pociętych kawałków, które analizuje osobno, wyrywając je z szerszego kontekstu.

Jak działa wyszukiwanie semantyczne

Tradycyjne wyszukiwanie opierało się na dopasowaniu słów kluczowych. Wpisałeś „buty do biegania” — wyszukiwarka szukała stron zawierających te słowa.

Wyszukiwanie semantyczne działa inaczej. Dopasowuje ZNACZENIE, nie słowa. Dzięki temu „buty do biegania” i „obuwie sportowe do joggingu” są rozumiane jako podobne zapytania, mimo że używają innych słów.

Jak to działa technicznie? Każdy tekst jest przekształcany w embedding — wektor liczbowy reprezentujący jego znaczenie. Następnie AI porównuje podobieństwo wektorowe między pytaniem użytkownika a dostępnymi fragmentami treści. Fragmenty o najbliższych wektorach są wybierane jako źródła.

Co decyduje o tym, czy Twój tekst zostanie zacytowany?

Pięć głównych czynników wpływa na to, czy AI wybierze Twoją treść:

Relewancja semantyczna — czy chunk rzeczywiście odpowiada na pytanie użytkownika. Nie chodzi o słowa kluczowe, ale o znaczenie.

Jakość i wiarygodność źródła — domain authority nadal ma znaczenie. AI preferuje źródła, którym „ufa”.

Struktura tekstu — czy odpowiedź jest łatwa do wyekstrahowania. Jasne definicje, listy, bezpośrednie stwierdzenia wygrywają z rozwlekłymi akapitami.

Bezpośredniość — czy odpowiedź jest na początku sekcji, czy zakopana gdzieś w środku tekstu.

Aktualność — dla niektórych zapytań świeższe treści są preferowane. Data publikacji i aktualizacji ma znaczenie.

Chunki, wektory, embeddingi — słownik nowego SEO

Nowe SEO wymaga nowego słownictwa. Oto kluczowe pojęcia, które musisz znać:

- Chunk — fragment tekstu przetwarzany przez AI

- Wektor — matematyczna reprezentacja znaczenia tekstu

- Embedding — proces zamiany tekstu na wektor

- Klasteryzacja — grupowanie fraz po podobieństwie semantycznym

Chunk (fragment)

Chunk to mały fragment tekstu — zazwyczaj od 100 do 500 tokenów — który AI przetwarza jako osobną jednostkę. To fundamentalne pojęcie dla zrozumienia, jak LLM-y „czytają” treści.

Dlaczego to ważne? AI nie analizuje całych stron jako jedności. Dzieli je na chunki i ocenia każdy osobno. Twoja świetna strona może mieć słabe chunki — i wtedy AI jej nie zacytuje.

Implikacja dla twórcy treści jest jasna: każda sekcja, każdy akapit powinien być samowystarczalny (self-contained). Sekcja H2 z kompletną odpowiedzią to dobry chunk. Długi akapit bez konkretów, który wymaga kontekstu z innych części strony, to słaby chunk.

Wektor (vector)

Wektor to matematyczna reprezentacja tekstu jako lista liczb. Można go traktować jak koordynaty w wielowymiarowej przestrzeni znaczeń — unikalna sygnatura semantyczna danego fragmentu.

Służy to porównywaniu podobieństwa tekstów. Jeśli dwa fragmenty mają bliskie wektory, mają podobne znaczenie — nawet jeśli używają innych słów.

Przykład: „samochód” i „auto” będą miały bliskie wektory, bo znaczą to samo. „Samochód” i „pomidor” — wektory odległe, bo nie ma związku semantycznego.

Embedding

Embedding to proces przekształcania tekstu w wektor za pomocą modelu AI. Embedding to proces, wektor to wynik.

Istnieją różne modele embeddingowe — OpenAI text-embedding-3-large, Cohere, Sentence Transformers i inne. Od jakości embeddingu zależy, jak dobrze AI „rozumie” Twój tekst i czy uzna go za odpowiedni do danego pytania.

Klasteryzacja (clustering)

Klasteryzacja to grupowanie fraz lub treści na podstawie podobieństwa wektorowego. W kontekście SEO oznacza to grupowanie słów kluczowych o podobnym znaczeniu.

Tradycyjne podejście: lista 1000 fraz grupowanych ręcznie po słowach. Klasteryzacja wektorowa: AI grupuje frazy po znaczeniu. W efekcie, zamiast listy 1000 fraz, otrzymujesz 30 klastrów tematycznych, gdzie każdy klaster zawiera frazy o tej samej intencji użytkownika.

Podobieństwo kosinusowe (cosine similarity)

Podobieństwo kosinusowe to miara podobieństwa dwóch wektorów — przyjmuje wartości od -1 do 1, gdzie 1 oznacza identyczne znaczenie. Tak AI decyduje, czy chunk „pasuje” do pytania użytkownika.

W praktyce similarity powyżej 0.7-0.8 oznacza, że fragment jest istotny dla danego zapytania.

GEO vs SEO — co się zmienia, co zostaje

GEO (Generative Engine Optimization) to optymalizacja treści pod silniki generatywne — ChatGPT, Perplexity, Gemini, Google AI Overviews. Celem jest być cytowanym źródłem w odpowiedziach AI. Spotkasz też inne nazwy tego samego zjawiska: LLMO (LLM Optimization) czy AIO (AI Optimization).

Co zostaje z tradycyjnego SEO?

Dobra wiadomość jest taka, że nie wyrzucasz wszystkiego, czego się nauczyłeś. Fundamenty SEO pozostają aktualne.

Jakość treści nadal jest podstawą. E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) wciąż działa. Autorytet domeny (DA/DR) wpływa na zaufanie, jakim AI obdarza Twoje źródło. Struktura nagłówków H1, H2, H3 pozostaje ważna. Mobile-first i szybkość ładowania to wciąż czynniki rankingowe. Linkowanie wewnętrzne i zewnętrzne buduje kontekst i autorytet.

Co się zmienia / co dodajemy

Zmiany dotyczą przede wszystkim sposobu myślenia o treściach i ich strukturze.

Od słów kluczowych do intencji i znaczenia. Semantyka staje się ważniejsza niż dokładne dopasowanie exact match. AI rozumie synonimy i kontekst.

Od optymalizacji strony do optymalizacji fragmentów. Każdy chunk musi działać samodzielnie — to nowy wymóg.

Nowe metryki. Obok tradycyjnych (pozycja, CTR, ruch organiczny) pojawiają się: obecność w AI Overviews, cytowania w ChatGPT/Perplexity.

Struktura odpowiedzi. Bezpośrednie odpowiedzi na początku sekcji stają się kluczowe.

Tabela porównawcza SEO vs GEO

| Aspekt | Tradycyjne SEO | GEO/LLMO |

| Cel | Pozycja w SERP | Cytowanie przez AI |

| Jednostka optymalizacji | Strona | Chunk (fragment) |

| Dopasowanie | Słowa kluczowe | Znaczenie semantyczne |

| Struktura | Dla crawlerów | Dla ekstrakcji AI |

| Metryka | Pozycja, CTR, ruch | Cytowania AI, widoczność w AIO |

| Co się liczy | Backlinki, DA | + Bezpośredniość odpowiedzi, struktura |

Jak pisać treści przyjazne dla LLM-ów — 7 zasad

Pisanie dla LLM wymaga konkretnych zmian w sposobie tworzenia treści. Stosuj poniższe zasady, aby zwiększyć szanse na cytowanie w odpowiedziach AI.

1. Odpowiadaj bezpośrednio na początku sekcji

Pierwsze jedno-dwa zdania każdej sekcji H2 powinny zawierać bezpośrednią odpowiedź na pytanie z nagłówka. Nie buduj napięcia. Nie ukrywaj odpowiedzi w środku akapitu.

Przykład: Nagłówek „Co to jest chunk?” → pierwsze zdanie: „Chunk to fragment tekstu o długości 100-500 tokenów, który AI przetwarza jako osobną jednostkę.”

2. Twórz samowystarczalne sekcje (self-contained chunks)

Każda sekcja H2 lub H3 powinna mieć sens bez czytania reszty artykułu. Unikaj sformułowań typu „jak wspomnieliśmy wyżej” — AI może wyciągnąć tylko ten jeden fragment i kontekst z innych części strony nie będzie dostępny.

Powtórzenie kluczowego kontekstu jest OK. Lepsze niż niezrozumiały chunk.

3. Używaj definicji i formatów „X to Y”

LLM-y uwielbiają jasne definicje. Format „[Pojęcie] to [definicja], które [zastosowanie/cecha]” jest idealny do cytowania.

Przykład: „Embedding to proces przekształcania tekstu w wektor liczbowy, który reprezentuje jego znaczenie semantyczne i umożliwia porównywanie podobieństwa treści.”

4. Stosuj listy i struktury łatwe do ekstrakcji

Listy numerowane sprawdzają się dla procesów krok po kroku. Listy punktowane dla cech i elementów. Tabele dla porównań. AI łatwiej ekstrahuje ustrukturyzowane dane niż płynny tekst.

Ale nie przesadzaj. Lista ma sens, gdy prezentuje równorzędne elementy. Nie zmieniaj każdego akapitu w listę na siłę.

5. Odpowiadaj na pytania „People Also Ask”

Sekcje FAQ z konkretnymi pytaniami i odpowiedziami to złoto dla GEO. Nagłówki H2/H3 w formie pytań (takich jak „Co to jest embedding?”) bezpośrednio trafiają w zapytania użytkowników.

Kluczowe: używaj pytań, które ludzie naprawdę zadają. Sprawdź PAA w Google, przeanalizuj zapytania w Search Console, posłuchaj klientów.

6. Buduj autorytet tematyczny (topical authority)

AI preferuje źródła, które są „ekspertami” w temacie. Jeden artykuł to za mało — potrzebujesz wielu powiązanych treści w klastrze tematycznym.

Linkowanie wewnętrzne między powiązanymi artykułami buduje kontekst. Pillar page + artykuły wspierające to struktura, którą AI rozumie jako kompetencję w temacie.

7. Aktualizuj treści regularnie

AI preferuje świeże źródła dla wielu zapytań. Dodawaj widoczne daty aktualizacji. Odświeżaj dane, statystyki, przykłady. Artykuł sprzed 3 lat z nieaktualnymi informacjami przegra z nowszym źródłem.

Analiza keyword gap pod kątem AI — nasze podejście

Nasze podejście do keyword gap łączy tradycyjną analizę z AI: eksportujemy dane z Ahrefs, wektoryzujemy frazy (zamieniamy na embeddingi), następnie klasteryzujemy je semantycznie. Efekt: zamiast listy tysięcy fraz otrzymujesz pogrupowane klastry tematyczne gotowe do zaplanowania strategii treści.

Problem z tradycyjną analizą keyword gap

Standardowy keyword gap to lista fraz, na które rankuje konkurencja, a Ty nie. Brzmi przydatnie, ale w praktyce dostajesz tabelę z tysiącem lub więcej fraz bez priorytetyzacji semantycznej.

Problem: które frazy są TEMATYCZNIE powiązane? Które powinny być w jednym artykule, a które w osobnych? Lista nie odpowie na te pytania.

Nasze rozwiązanie: Keyword gap + wektoryzacja + klasteryzacja AI

Stworzyliśmy proces, który przekształca surowe dane w actionable strategię:

Krok 1: Eksport danych z Ahrefs — Twoja strona vs konkurencja (do 5 konkurentów).

Krok 2: Program tworzy dwa zestawienia. Tabela keyword gap pokazuje frazy, na które jest widoczny każdy konkurent, a Ty nie. Tabela zbiorcza zawiera wszystkie unikalne frazy od konkurencji z danymi o CPC, Volume i KD.

Krok 3: Wektoryzacja fraz — każda fraza jest przekształcana w embedding (wektor liczbowy reprezentujący jej znaczenie).

Krok 4: Klasteryzacja AI — algorytm grupuje frazy o bliskim znaczeniu semantycznym. „Buty do biegania”, „obuwie sportowe”, „running shoes” trafiają do jednego klastra.

Krok 5: Output: klastry tematyczne z propozycjami tematów na blog, gotowe do wdrożenia.

Co zyskujesz?

Zamiast przebijać się przez 1000 fraz, dostajesz 20-30 jasno zdefiniowanych klastrów tematycznych. Każdy klaster to potencjalny pillar page lub seria artykułów. Priorytety są oparte na semantyce, nie tylko na volume. Strategia contentowa opiera się na realnych lukach względem konkurencji.

Przykład w praktyce

Dla klienta e-commerce wykonaliśmy analizę vs 5 konkurentów. Keyword gap wygenerował 2500 fraz. Po klasteryzacji wektorowej otrzymaliśmy 35 klastrów tematycznych. Top 5 klastrów stało się planem content na Q1. Efekt: treści targetują grupy semantyczne (intencje użytkowników), nie pojedyncze frazy.

Klasteryzacja fraz wektorowa — od danych do strategii treści

Klasteryzacja wektorowa grupuje frazy kluczowe na podstawie podobieństwa semantycznego (znaczenia), nie tylko słów. Każda fraza jest zamieniana na wektor (embedding), następnie algorytm grupuje frazy o bliskich wektorach. Efekt: synonimy i frazy o tej samej intencji trafiają do jednej grupy, co eliminuje kanibalizację i daje jasne tematy do content planu.

Dlaczego tradycyjne grupowanie fraz zawodzi

Grupowanie po słowach prowadzi do absurdów. „Buty sportowe” i „obuwie do biegania” trafiają do różnych grup, mimo że odpowiadają na tę samą intencję użytkownika. „Jak schudnąć” i „odchudzanie skuteczne metody” — znowu różne grupy.

W efekcie powielające się treści prowadzą do kanibalizacji słów kluczowych i nieefektywnej strategii contentowej.

Jak działa klasteryzacja wektorowa

Proces jest prosty koncepcyjnie, choć wymaga odpowiednich narzędzi:

Krok 1: Każda fraza jest przekształcana w embedding — wektor liczbowy reprezentujący jej znaczenie.

Krok 2: Algorytm klasteryzacji (k-means, HDBSCAN lub hierarchiczny) grupuje frazy o bliskich wektorach.

Krok 3: Każdy klaster to grupa fraz o podobnym ZNACZENIU — niezależnie od użytych słów.

Efekt: „buty sportowe”, „obuwie do biegania”, „sportowe buty do ćwiczeń”, „running shoes” — jeden klaster, jeden temat.

Od klastrów do tematów na blog

Każdy klaster staje się jednym tematem lub pillar page. Analiza klastra odpowiada na pytanie: która fraza ma największy volume? To będzie główne słowo kluczowe artykułu. Pozostałe frazy w klastrze to LSI, pytania do FAQ, podtematy do rozwinięcia.

Hierarchia klastrów przekłada się na hierarchię treści: duże klastry to pillar pages, małe klastry to artykuły wspierające.

Narzędzia do klasteryzacji wektorowej

Można używać custom skryptów w Pythonie (scikit-learn, sentence-transformers). Są też platformy SaaS jak Keyword Insights czy Cluster AI. My zbudowaliśmy własne narzędzie, które automatyzuje cały proces — od eksportu Ahrefs do gotowych klastrów z rekomendacjami.

Optymalizacja pod AI Overviews — jak analizować i wdrażać

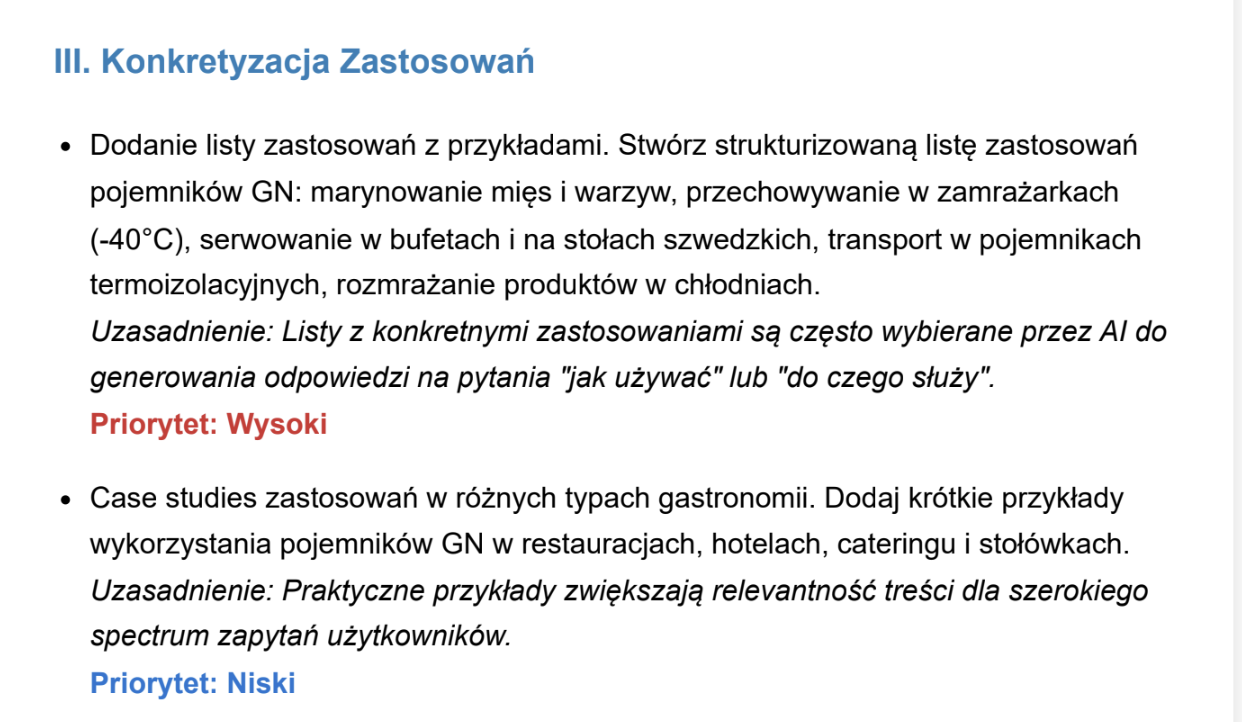

Nasze narzędzie do optymalizacji AIO analizuje, jak Google AI Overviews odpowiada na wybrane zapytania: jakie źródła cytuje, jaką strukturę stosuje, jakie elementy (listy, definicje) wykorzystuje. Na tej podstawie tworzymy konkretne zalecenia do treści — co zmienić, żeby zwiększyć szanse na cytowanie.

Czym są AI Overviews i dlaczego warto tam być

AI Overview to odpowiedź generowana przez AI, która pojawia się na górze wyników Google — nad wszystkimi organicznymi wynikami. Dla SEO to problem: użytkownik dostaje odpowiedź bez klikania. Ale to też szansa: jeśli jesteś cytowanym źródłem, zyskujesz widoczność i autorytet.

Być widocznym w AI Overview to jak być w „pozycji zero” — tylko trudniejsze i bardziej wartościowe.

Inteligentny Audytor Treści — nasze podejście do analizy AIO

W Veneo Performance stworzyliśmy Inteligentnego Audytora Treści — narzędzie, które w kilka chwil wykonuje pracę całego zespołu analityków SEO. Do tej pory taki audyt zajmował zespołowi ekspertów długie godziny. Teraz możesz go mieć w kilka chwil — precyzyjniej, taniej, skuteczniej.

Jak to działa? Wybierasz tekst do analizy, a nad jego optymalizacją pracują jednocześnie trzy wirtualne osobowości:

Analityk — błyskawicznie porównuje Twoją treść z tym, co generuje sztuczna inteligencja Google. Wychwytuje każdy brak, każdą lukę w danych i definicjach. Sprawdza, czego brakuje, żeby Twój content miał szansę na cytowanie.

Strateg — to mózg operacji. Odsiewa fałszywe alarmy, nadaje priorytety i zamienia problemy w klarowne rekomendacje biznesowe. Nie dostajesz listy 100 błędów — dostajesz uporządkowane zadania według ważności.

Konsultant biznesowy — zamyka cały proces w eleganckim, profesjonalnym raporcie. Raport nie tylko pokazuje, co poprawić, ale także dlaczego to ma znaczenie i jak przełoży się na wyniki.

Co otrzymujesz w raporcie?

W efekcie otrzymujesz konkretne wskazówki — gotowe do wdrożenia, poparte danymi rynkowymi, czytelnie zwizualizowane. To nie kolejny skrypt generujący listę technicznych błędów. To narzędzie, które łączy wszystkie elementy analizy SEO potrzebnej do skutecznej optymalizacji pod AI.

Raport zawiera: porównanie Twojej treści z odpowiedziami AI Google na kluczowe zapytania, zidentyfikowane luki (brakujące definicje, dane, elementy strukturalne), priorytetyzowane rekomendacje od najważniejszych do „nice to have”, uzasadnienie biznesowe oraz konkretne wskazówki wdrożeniowe.

Przykładowe zalecenia z audytu

Zalecenia są konkretne i actionable:

„Dodaj bezpośrednią definicję [pojęcia] w pierwszym zdaniu sekcji — AI Overview cytuje definicje, a Twoja treść jej nie zawiera.”

„Zamień akapit opisowy na listę numerowaną — AI Overview dla tego zapytania używa formatu listy kroków, Twój format tekstowy jest trudniejszy do ekstrakcji.”

„Uzupełnij brakujące dane o [X] — konkurencja jest cytowana za te informacje, u Ciebie ich brakuje.”

„Dodaj sekcję FAQ z pytaniami [Y, Z] — pojawiają się w People Also Ask i AI Overview odnosi się do nich.”

Sprawdziliśmy Inteligentnego Audytora w projektach dla naszych klientów i szybko odnotowaliśmy wzrost wyników. Treści zoptymalizowane na podstawie rekomendacji zaczęły pojawiać się w AI Overviews — a to przekłada się na widoczność i autorytet marki.

Przyszłość: Co dalej z SEO w erze LLM-ów?

SEO nie umiera, ale ewoluuje. Przyszłość należy do tych, którzy łączą tradycyjne SEO z optymalizacją pod LLM-y (GEO/LLMO). Kluczowe kompetencje to: rozumienie semantyki, praca z wektorami, tworzenie treści „chunk-friendly” i ciągła analiza, jak AI wybiera źródła do cytowania.

SEO nie umiera — ewoluuje

Tradycyjne SEO zostanie z nami. Google nadal dominuje w wyszukiwaniu, a LLM-y często bazują na wynikach Google przy wyborze źródeł. Ale samo SEO już nie wystarczy — trzeba dodać warstwę GEO/LLMO.

Przyszłość to SEO + GEO jako standard. Nie alternatywa, nie wybór „albo-albo”. Obie kompetencje są niezbędne.

Trendy do obserwowania

Wyszukiwanie konwersacyjne rośnie — użytkownicy zadają pytania pełnymi zdaniami, nie wpisują pojedynczych słów kluczowych.

AI-native search engines zyskują popularność — Perplexity, You.com, SearchGPT to nie eksperymenty, to rosnąca konkurencja dla Google.

Integracja AI w tradycyjne wyszukiwarki przyspiesza — Google i Bing inwestują w AI Overviews i podobne rozwiązania.

Personalizacja odpowiedzi AI może zmienić reguły gry — różni użytkownicy mogą otrzymywać różne odpowiedzi na to samo pytanie.

Jakie kompetencje rozwijać?

Zrozumienie semantyki i NLP (natural language processing) staje się fundamentem. Umiejętność pracy z danymi wektorowymi — embeddingami, klasteryzacją — to praktyczna przewaga. Analiza zachowań AI wymaga nauki: jak testować, co jest cytowane, dlaczego.

Tworzenie treści „chunk-friendly” to nowa kompetencja copywriterska. Automatyzacja i narzędzia AI w workflow SEO — nie zastąpią człowieka, ale zwiększą efektywność.

Kto wygra w nowej erze?

Twórcy treści, którzy rozumieją OBA paradygmaty — tradycyjne SEO i GEO. Marki budujące autorytet tematyczny, nie produkujące content na ilość. Organizacje inwestujące w jakość i strukturę treści. I ci, którzy szybciej adaptują się do zmian — bo zmiany będą postępować.

FAQ

Czym różni się GEO od tradycyjnego SEO?

GEO (Generative Engine Optimization) to optymalizacja pod silniki AI (ChatGPT, Perplexity, AI Overviews), podczas gdy SEO skupia się na pozycji w klasycznych wynikach Google. GEO koncentruje się na strukturze fragmentów (chunków), bezpośredniości odpowiedzi i semantyce — tak, aby AI chciało zacytować Twoje treści jako źródło.

Co to jest chunk w kontekście SEO i LLM-ów?

Chunk to fragment tekstu (zazwyczaj 100-500 tokenów), który LLM przetwarza jako osobną jednostkę. AI nie analizuje całych stron — dzieli je na chunki i ocenia każdy osobno. Dla twórcy treści oznacza to, że każda sekcja powinna być samowystarczalna i zawierać kompletną odpowiedź.

Jak sprawdzić, czy moje treści są cytowane przez AI?

Ręcznie: zadaj pytania związane z Twoją treścią w ChatGPT, Perplexity, Google (z AI Overview) i sprawdź źródła. Automatycznie: użyj narzędzi do monitoringu cytatów AI lub naszego narzędzia do analizy AIO. Śledź, czy Twoja domena pojawia się jako cytowane źródło.

Czy tradycyjne SEO nadal ma znaczenie?

Tak, absolutnie. LLM-y często bazują na wynikach wyszukiwania Google, więc wysoka pozycja zwiększa szanse na cytowanie. Autorytet domeny, E-E-A-T, jakość treści — to wszystko nadal działa. GEO to rozszerzenie SEO, nie zamiennik.

Jak zacząć z optymalizacją pod LLM-y?

Zacznij od struktury: dodaj bezpośrednie odpowiedzi na początku sekcji, twórz samowystarczalne fragmenty, używaj definicji i list. Następnie analizuj: sprawdź, jak AI odpowiada na zapytania w Twojej branży i co cytuje. Na koniec: testuj i iteruj na podstawie wyników.

Co to są embeddingi i dlaczego są ważne dla SEO?

Embedding to matematyczna reprezentacja tekstu w formie wektora liczbowego. Dzięki embeddingom AI „rozumie” znaczenie tekstu i może porównywać podobieństwo różnych fragmentów. W praktyce: jeśli embedding Twojego tekstu jest bliski embeddingowi pytania użytkownika, masz większą szansę na cytowanie.

Podsumowanie

Pisanie dla LLM-ów to nie rewolucja — to ewolucja SEO. Nie wyrzucasz tego, czego się nauczyłeś przez lata. Dodajesz nową warstwę, która zwiększa szanse na widoczność w erze AI.

Trzy rzeczy do wdrożenia już dziś:

Struktura „chunk-friendly” — bezpośrednie odpowiedzi na początku każdej sekcji, samowystarczalne fragmenty, które mają sens bez kontekstu z reszty strony.

Semantyka ponad słowa kluczowe — myśl o znaczeniu i intencji użytkownika, nie tylko o dokładnym dopasowaniu fraz. Używaj definicji, list, formatów łatwych do ekstrakcji.

Analiza AI — regularnie sprawdzaj, co jest cytowane przez ChatGPT, Perplexity, AI Overviews. Adaptuj treści na podstawie wyników, nie na podstawie przeczuć.

Jeśli chcesz zobaczyć, jak działa analiza keyword gap z klasteryzacją wektorową lub nasze narzędzie do optymalizacji pod AI Overviews — skontaktuj się z nami. Pokażemy Ci, jak wygląda strategia content oparta na danych semantycznych, nie tylko na volume i pozycjach.

Od której zmiany zaczniesz w swoich treściach?