Dobre praktyki SEO przy tworzeniu stron internetowych

| Veneo Performance | SEO/SXOTo jak ważne przy tworzeniu stron internetowych jest uwzględnienie działań optymalizacyjnych pod wyszukiwarki (SEO), wie każdy właściciel strony, bądź sklepu internetowego, który o tym zapomniał. W późniejszych etapach przekładało się to na koszty audytów i poprawek programistycznych, nie mówiąc już o stratach, jakie powstały z tytułu braku optymalizacji podstawowych elementów, a co za tym idzie braku odpowiednich pozycji w Google i ruchu, jakie mogły one przynieść na sklep.

Spis treści:

W celu uzmysłowienia co tak naprawdę jest najważniejsze prezentujemy garść dobrych praktyk przy budowie stron internetowych. Oczywiście, jeśli wdrożenie ich w życie wiązałoby się z jakimikolwiek trudnościami, lub wymagało dodatkowych konsultacji, zalecamy kontakt z agencją, która zajmie się tematem przygotowania odpowiednich wytycznych.

Podstawowe praktyki

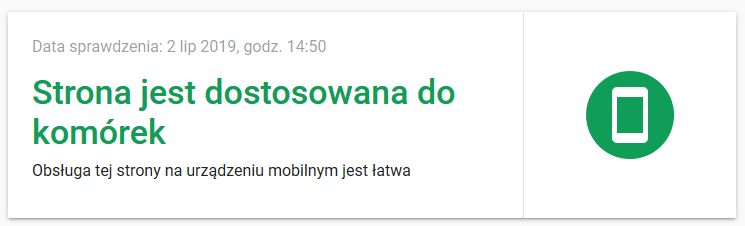

1. Dopasowanie do urządzeń mobilnych

Obecnie ruch z urządzeń mobilnych przewyższa znacząco ruch desktopowy i Google zaczął mocniej przywiązywać uwagę do tego, jak dana witryna wyświetla się na urządzeniach mobilnych. Dlatego pierwszym i najważniejszym elementem jest dostosowanie witryny pod urządzenia mobilne.

W jaki sposób można sprawdzić poprawność dostosowania witryny pod urządzenia mobilne? Na przykład korzystając z tego narzędzia: https://search.google.com/test/mobile-friendly

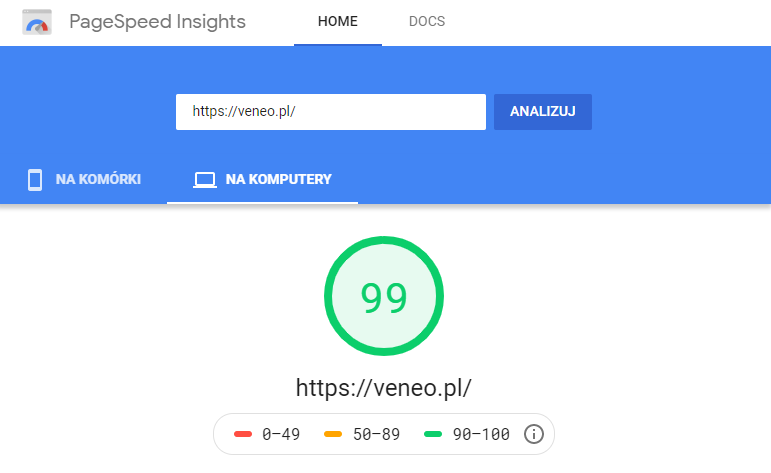

2. Szybkość ładowania

Kolejnym bardzo ważnym punktem optymalizacji strony jest prędkość jej wczytywania. To obecnie jeden z największych problemów, z którymi borykają się różne serwisy, a to właśnie ten czynnik decyduje, czy użytkownik zostanie na stronie, czy opuści ją niezwłocznie, co najczęściej może skutkować zaniżaniem pozycji przez Google.

Google podaje rekomendacje, by czas odpowiedzi serwera wynosił do 200 ms, a czas renderowania witryny do 1 s. Są to wyniki trudne do zrealizowania, jednak warto je optymalizować i dążyć do ich zminimalizowania.

Narzędzia do sprawdzenia szybkości ładowania witryny: https://developers.google.com/speed/pagespeed/insights/?hl=pl & https://www.webpagetest.org/

3. Mapa witryny

Posiadanie mapy witryny jest niezbędne, by pokazać wyszukiwarkom, które adresy są naszym zdaniem najważniejsze i które w pierwszej kolejności powinny być indeksowane. Należy pamiętać, by były one na bieżąco aktualizowane.

Najlepszym rozwiązaniem jest stworzenie generatora sitemapy, który będzie generował plik sitemap.xml zawierający wszystkie strony w serwisie zwracające status HTTP 200, a w tym niezawierające stron z noindex oraz tylko stron kanonicznych (tzn. tylko te strony, które wskazują linkiem kanonicznym na siebie bądź bez linków kanonicznych).

- Sitemapy mogą być również zgłaszane poprzez plik siteindex grupujący wiele plików map witryn (więcej informacji http://www.sitemaps.org/pl/protocol.html). Serwis musi posiadać mechanizm, który w postaci sitemap będzie zgłaszał wszystkie adresy URL występujące w serwisie.

- W przypadku strony statycznej czy takiej, na której nowe treści pojawiają się dość rzadko, można rozważyć ręczne stworzenie mapy witryny (można taką mapę wygenerować automatycznie za pomocą gotowych narzędzi, np. http://www.xml-sitemaps.com/) w formacie .xml i dodaniem jej poprzez Google Search Console (więcej: https://support.google.com/webmasters/answer/183668?hl=pl ).

4. Przyjazne adresy URL

Najlepsze adresy stron internetowych są proste i przejrzyste, a co się z tym wiąże: łatwe do zapamiętania przez użytkownika i przyjazne pracy robotów indeksujących. Dobrze skonstruowany adres pomoże użytkownikowi w nawigacji na stronie – będzie dla niego czytelne, w którym miejscu serwisu aktualnie się znajduje. Oprócz wartości czysto logistycznej, dobrze przemyślany adres posiada również atrakcyjny wygląd, który może zachęcić użytkownika do podlinkowania go w innych źródłach, np. w social mediach.

Jak więc stworzyć przyjazny adres URL?

- Przede wszystkim należy pamiętać o tym, aby dokładnie opisywał on zawartość podstrony, do której zostanie odesłany odwiedzający. Warto użyć w tym celu słów kluczowych, które będą odpowiadały na konkretne zapytanie użytkownika. Dzięki temu pracujące algorytmy będą mogły dobrze skategoryzować naszą witrynę i uznać ją za wartościową, przez co zostanie ona wymieniona w wynikach wyszukiwarki. Należy przy tym pamiętać, aby nie przesadzić z ilością użytych słów kluczowych, ponieważ Google może wówczas zakwalifikować taką praktykę jako spam. Warto również zwrócić uwagę na to, aby adres nie był zbyt długi (im dłuższy jest adres URL, tym mniejsza jego część będzie wyświetlana w wynikach wyszukiwania). To ostatnie jest szczególnie ważne w przypadku wpisów blogowych, jeśli aliasy dla danego wpisu są generowane automatycznie, a tytuł wpisu sam w sobie jest zbyt długi. Jeśli istnieje możliwość ręcznego skrócenia takiego aliasu, należy to zrobić (wówczas z dłuższej nazwy robimy krótszą).

- Pamiętajmy, że jeśli dana witryna prowadzona jest w języku polskim, dobrze jest trzymać się danej wersji językowej. Prawidłowy adres URL powinien wówczas wyglądać następująco: https://nazwadomeny.pl/o-nas, nie zaś: https://nazwadomeny.pl/about

- Oddzielając od siebie wyrazy, obowiązkowo używajmy myślników. Roboty wyszukiwarek automatycznie odczytują je jako przerwy między słowami. W żadnej sytuacji nie należy używać spacji oraz znaków podkreślenia, które dla Google są po prostu nieczytelne.

- Nie powinno się również używać polskich znaków oraz znaków specjalnych (tj.!, %, itp.), podobnie jak wielkich liter, przez które użytkownik może zostać przeniesiony na nieistniejącą stronę.

5. Elementy graficzne

Każda grafika w serwisie (za wyjątkiem grafik służących jako stałe elementy strony – oprócz logotypu) powinna mieć opis alternatywny alt. Najlepiej, żeby było to słowo kluczowe. Pozwoli to robotowi Google rozpoznać ten element na stronie, co bez opisu rodziłoby problemy, ponieważ wyszukiwarka nie jest w stanie samodzielnie w stu procentach odczytać zawartości grafiki. Takie opisy powinny się składać z 2-3 słów i być napisane poprawnie, wraz z polskimi znakami. Atrybut title jest opcjonalny – nie ma znaczenia pod kątem SEO, jednak może być przydatny dla użytkownika.

6. Dynamiczne meta tagi

Serwis powinien posiadać dynamicznie generowany schemat title oraz description, wraz z możliwością jego ręcznej edycji dla każdej z podstron indywidualnie.

Automatyczne generowanie description na podstawie treści strony jest bardzo wygodnym rozwiązaniem. Google wówczas, pobierając tekst z naszej strony, ustala treść najlepiej odpowiadającą na zapytanie użytkownika. Niestety, choć wygodny, nie jest to bezkosztowy zabieg. Często bowiem jest pobierana zbyt duża ilość tekstu i nie wyświetla się on w całości w wynikach wyszukiwania. Trzeba być również przygotowanym na to, że wygenerowany opis będzie zawierać przypadkowy zbiór dat, nazwisk autorów czy nazw kategorii, co często zniechęci użytkownika, ze względu na średnio czytelny i mało przydatny opis. Rzecz jasna – istnieje tutaj alternatywa. Jeśli omawiana treść jest wpisywana ręcznie, wówczas posiadamy możliwość wyboru, w jaki sposób zachęcimy użytkownika do kliknięcia w link do naszej witryny. Długość takiego opisu może wynosić nawet do 320 znaków (w przypadku wyszukiwarki Google). Pamiętajmy jednak, że dłuższy tekst nie zostanie wyświetlony.

W description mogą się znaleźć słowa kluczowe, jednak nie mają one znaczenia z punktu widzenia pozycjonowania, a jedynie użytkownika – po wpisaniu danej frazy w wyszukiwarkę zostanie ona w opisie pod linkiem automatycznie pogrubiona, co przyciąga wzrok i ułatwia wyszukiwanie informacji.

Najważniejsze frazy na danej podstronie powinny być umiejscowione na początku title. Warto tu użyć ważnego dna nas słowa kluczowego i dzięki temu nakierować wyszukiwarkę na tematykę strony. Np. na podstronie produktu mogłoby to wyglądać następująco:

Title: [Nazwa podstrony] – [Dodatkowe słowa kluczowe] – [nazwa strony]

Uwagi do title:

– Title poszczególnych podstron powinny być unikatowe, ponieważ każda podstrona witryny zawiera inną tematykę.

– Długość title nie może przekraczać około 70 znaków (inaczej title nie wyświetli się w całości w wynikach wyszukiwania).

7. Nagłówki H1-H6

Nagłówki H1-H6 są to tytuły, podtytuły i śródtytuły, uporządkowane hierarchicznie od najbardziej ważnych do najmniej istotnych. Właściwe oznaczanie poziomu istotności danego nagłówka jest szczególnie ważne z punktu widzenia pozycjonowania stron.

Na każdej stronie powinien być tekstowy nagłówek H1. Określa on główną zawartość strony, przez co ze wszystkich nagłówków ma on największe znaczenie pod względem SEO. Należy pamiętać, że powinien mieć większy rozmiar, niż inne nagłówki.

Tak więc na przykład w przypadku:

– Strony głównej nagłówkiem H1 będzie nazwa serwisu z dodatkowym tekstem zawierającym najważniejsze słowa kluczowe.

– Stron zbiorczych nagłówkiem H1 (np. kategorii) będzie tytuł strony/kategorii.

Pamiętajmy jednak o tym, aby nie używać nagłówków o niższej hierarchii, jeśli wpierw nie wykorzystaliśmy tych o wyższej istotności. Jeśli nie ma takiej potrzeby, do dobrego pozycjonowania wystarczą nawet tylko nagłówki H1 oraz H2.

Szczególnie ważne jest to, aby w nagłówkach zamieszczać słowa kluczowe (np. nazwę produktu), ponieważ są wtedy bardziej widoczne dla robotów wyszukiwarki.

8. Tagi dla robotów wyszukiwarek

Jednym z najważniejszych zadań meta-tagów jest przekazywanie informacji dotyczących indeksowania robotom wyszukiwarek. W takim przypadku tagi będą używane do określenia, czy dana witryna ma zostać dodana do indeksu wyszukiwarki oraz czy będzie się wyświetlała jako jeden z wyników wyszukiwania, a także czy roboty powinny śledzić czy raczej ignorować linki do stron wychodzących.

Należy więc pamiętać, aby serwis na wszystkich swoich podstronach zawierał w sekcji <head> następujące metatagi:

<meta name=”robots” content=”index, follow”>

9. Treść

Przede wszystkim, musimy zadbać o to, aby treści na stronie były unikatowe. Nie powinno się kopiować tej samej treści (duplicate content) w obrębie danej strony lub kilku serwisów – wyszukiwarka może uznać taką stronę za mniej wartościową i wyświetlać ją niżej w wynikach wyszukiwania.

Należy też przewidzieć miejsce we wszystkich podstronach serwisu na dodatkową treść, która pomoże w pozycjonowaniu określonych fraz. Im więcej treści, tym lepiej, dlatego takie miejsce powinno uwzględniać możliwość dodania dużego tekstu, np. powyżej 2000 znaków.

10. Przekierowania 301

Przekierowanie 301 to metoda odesłania użytkowników ze starej wersji adresu URL do jej aktualnej odsłony. Jest to o tyle istotne, że jeśli każda próba uzyskania dostępu do wcześniej istniejących treści spotka się z niepowodzeniem i wyświetleniem błędu 404, wówczas może prowadzić to negatywnego odbioru naszej witryny i w konsekwencji zmniejszenia ruchu na stronie.

Należy zatem pamiętać, że przekierowanie 301 jest niezbędne do utrzymania konwersji oraz wcześniej zdobytej pozycji w wynikach wyszukiwania.

Już na samym początku trzeba zdecydować, czy serwis będzie dostępny pod domeną z „www” czy bez „www”, a następnie wykonać przekierowanie. Ważne będzie powiązanie wszystkich wersji danej domeny (http://, www, itp.) z jedną główną. W przypadku zmiany struktury linków w serwisie, należy przekierować stare adresy w serwisie na nowo powstałe – również przy pomocy przekierowania 301. Podobnie postępuje się w przypadku zmiany nazwy domeny.

Przekierowania można ustawić następująco:

– domena strona główna stara -> domena strona główna nowa

– domena zakładka stara -> domena zakładka nowa

– domena wpis na blogu stara -> domena wpis na blogu nowa etc.

To samo dotyczy wszystkich subdomen. Te elementy na starej domenie lub subdomenie, które nie mają odpowiedników na nowej, możemy przekierować do innej strony w ramach serwisu, która odpowiada jej merytorycznie (lub której pozycję chcemy wzmocnić).

11. Linkowanie wewnętrzne i zewnętrzne

Linki możemy podzielić na dwie główne kategorie, jakimi są linki wewnętrzne oraz linki zewnętrzne.

Linkowanie zewnętrzne polega na zamieszczaniu wewnątrz strony odnośników prowadzących do innych witryn. Tworzy to wygodne dla użytkownika „przejścia” między różnymi domenami. W przypadku tego rodzaju linkowania zazwyczaj stosuje się atrybut nofollow, aby niepotrzebnie nie przekazywać mocy strony innym serwisom (chyba że z jakichś przyczyn, np. zamieszczając linki sponsorowane, chcemy zastosować atrybut dofollow).

Linkowanie wewnętrzne pomaga użytkownikom oraz robotom indeksującym przemieszczać się w obrębie jednej witryny. Są to wszystkie linki pojawiające się wewnątrz strony, prowadzące do jej innych podstron oraz wpisów. W przypadku linkowania wewnętrznego stosujemy linki dofollow (domyślnie linki posiadają atrybut rel=” dofollow”). W miarę możliwości staramy się linkować pomiędzy stronami w ramach jednego serwisu, ponieważ wtedy równomiernie rozkłada się moc na stronie.

Rekomendujemy, aby podczas linkowania pomiędzy własnymi serwisami stosować atrybut rel=”dofollow” w celu przekazywania mocy.

12. Strona błędu 404

Element, o którym często się zapomina, a którego brak powoduje utratę potencjalnego użytkownika, gdy trafiając na niedziałający adres nie zostanie odpowiednio pokierowany dalej. Z tego powodu warto zadbać o optymalizację strony błędu 404. Ciekawy tekst i grafika przyciągająca uwagę mogą wzbudzić zainteresowanie użytkownika, który mimo chwilowego niepowodzenia, wciąż będzie miał chęć, aby dotrzeć naszego contentu. W tak powstałej stronie powinny również znaleźć się funkcjonalne dla odbiorcy elementy, jak na przykład: odnośnik do strony głównej oraz zakładka „kontakt” ułatwiająca odnalezienie nas w sieci.

Strona błędu 404 powinna być wyświetlana bezpośrednio po wejściu na już nieistniejący adres. Nieprawidłowe jest automatyczne przekierowanie nieistniejących stron na strony typu /404.html. Należy również pamiętać o tym, że strony błędu 404 powinny zwracać status HTTP 404.

13. Reklamy

Rekomendujemy przestrzeganie standardów przedstawionych na stronie: https://www.betterads.org/standards/

Google jest członkiem opisanej tam koalicji. Skutkuje to tym, że Google Chrome będzie blokował wszystkie reklamy na witrynie, jeśli strona zostanie oceniona jako łamiąca przyjęte standardy.

14. HTTPS

HTTPS (z ang. Hypertext Transfer Protocol Secure) jest szyfrowaną wersją protokołu HTTP. Stosuje się go do witryn, od których wymagamy większego bezpieczeństwa (znajdziemy go na przykład przy adresach URL stron banków internetowych, sklepów internetowych oraz różnego rodzaju witryn, gdzie użytkownicy mają dostęp do dodawania własnej treści).

Warto mieć na względzie to, że Google Chrome będzie określał strony z HTTP jako niebezpieczne. Z perspektywy pozycjonowania rekomendujemy, aby nowo powstałe strony tworzone były na podstawie protokołu HTTPS.

15. Nawigacja

Dla użytkownika jednym z funkcjonalnie najważniejszych narzędzi jest nawigacja serwisu. Dobrze skonstruowana i czytelna, powinna znajdować się na każdej podstronie witryny. Ważne jest to, aby zawierała wszystkie najważniejsze linki, które będą umożliwiały użytkownikowi swobodne poruszanie się po całym serwisie.

16. Odnośniki „więcej”

Rekomenduje się nieużywanie odnośników „czytaj więcej” (i podobnych) przy treściach, które są zajawką. Odnosi się to także do zdjęć (wyjątek: sytuacja, gdy zdjęcie służy jako slider lub baner).

Żeby zachować możliwość kliknięcia np. w miniaturkę posta odsyłającą nas do dalszej treści, można zastosować skrypt JS.

Należy pamiętać o tym, że link <a> do treści powinien znajdować się tylko na tytule treści.

Opcjonalne praktyki

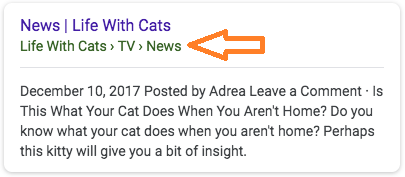

Okruszki (breadcrumbs)

Umożliwiają one użytkownikom śledzenie ich aktualnej lokalizacji w strukturze nawigacyjnej serwisu. Ostatni element ścieżki jest zawsze nieklikany i jest powtórzonym tytułem strony.

Odpowiednie zmodyfikowanie okruszków w oparciu o wytyczne Google pozwoli na ich efektywne wyświetlanie w bezpłatnych wynikach wyszukiwania, dzięki czemu istnieje większa szansa na zwiększenie ilości kliknięć.

Wszystkie niezbędne informacje, jak wdrożyć mechanizm okruszków zgodnie z zaleceniami Google znajdują się pod adresem: http://support.google.com/webmasters/bin/answer.py?hl=pl&hlrm=en&answer=185417

Zaleca się wdrożenie mechanizmu okruszków opierając się o schemat mikrodanych: https://support.google.com/webmasters/answer/176035

Inne wersje językowe serwisu

Do informowania Google, jaki adres URL powinien być prezentowany poszczególnym wersjom językowym wyszukiwarki, należy wykorzystać adnotacje rel=”alternate” hreflang=”x”.

Jeżeli posiadamy stronę w języku polskim oraz jej obcojęzyczne odpowiedniki, wówczas, aby poinformować Google, pod jakimi adresami znajdują się pozostałe wersje językowe, należy w sekcji <head> strony umieść elementy wskazujące na pozostałe wersje językowe witryny.

Taki element musi być zbudowany w następujący sposób:

<link rel=”alternate” hreflang=”en” href=”http://nazwa-serwisu.com/ ” />

<link rel=”alternate” hreflang=”de” href=”http://nazwa-serwisu.de/ ” />

Będzie to wyglądało podobnie dla innych wersji językowych.

Kody dla poszczególnych języków można znaleźć tutaj: Kody języków. Jeśli polska wersja witryny posiada linki do treści w języku niemieckim, angielskim, francuskim, czeskim, itp., to strona polskojęzyczna musi zawierać linki z atrybutami rel=”alternate” hreflang=”x” do wersji niemieckiej, angielskiej, francuskiej, czeskiej itp. One z kolei muszą zawierać podobne linki wskazujące cztery pozostałe wersje językowe (w tym polską).

Uwaga! Atrybuty rel=”alternate” hreflang=”x” działają na poziomie strony, a nie witryny – w związku z tym należy odpowiednio oznaczyć każdy zestaw stron (w tym stronę główną).

Więcej informacji: https://support.google.com/webmasters/answer/189077?hl=pl

Google Search Console

Weryfikacja strony w Google Search Console przyspieszy proces indeksacji, a także umożliwi dostęp do statystyk oraz komunikatów dotyczących stanu witryny.

Taka weryfikacja odbywa na kilka sposobów.

Pierwszym sposobem może być dodanie pliku do głównego katalogu serwisu. Wówczas serwis w katalogu głównym będzie zawierać plik weryfikacyjny wygenerowany na koncie SC.

Drugi sposób to połączenie konta Google Analytics z SC – koniecznie należy przy tym posiadać dostęp administracyjny do konta Google Analytics.

O innych metodach weryfikacji można przeczytać na stronie: https://support.google.com/webmasters/answer/35179?hl=pl

Plik robots.txt

Wyszukiwarki internetowe są w stanie rozpoznać zawartość witryny dzięki pracy tzw. robotów indeksujących. Plik robots.txt jest jednym z najprostszych narzędzi komunikacyjnych, dzięki któremu możemy się z nimi efektywnie porozumiewać – jest to bowiem pierwszy element witryny, którego poszukują.

Plik robots.txt składa się z komend zapisanych w zgodzie ze standardem Robots Exclusion Protocol, czyli swoistym „językiem” zrozumiałym dla robotów. Dzięki tak stworzonemu plikowi będziemy mogli ukierunkować zachowanie botów – wpłynąć na ich dostęp do poszczególnych podstron oraz wpłynąć na kierunek ich ruchu.

Aby plik robots.txt mógł prawidłowo funkcjonować, musi zostać zamieszczony w katalogu głównym domeny i być dostępy pod adresem http://nazwa-serwisu.pl/robots.txt. Jest to szczególnie ważne, ponieważ zamieszczenie takiego pliku w innej lokalizacji jest dla robotów indeksujących po prostu nieczytelne.

Warto zdawać sobie sprawę z tego, że plik robots.txt jest dla botów wyłącznie pewną sugestią, jak ma wyglądać ich prawidłowe zachowanie. Podczas gdy roboty popularnych wyszukiwarek internetowych powinny respektować nasze komendy, tak te pracujące dla wyszukiwarek „niszowych” mogą je zignorować.

Początkowo stworzony przez nas plik może wyglądać w sposób następujący:

User-agent: *

Allow: /

Informacje o pliku robots.txt: https://support.google.com/webmasters/answer/6062608?hl=pl